提供的ollama下载是win版的安装包哦。

ollama是一款开源的语言模型服务工具,可以帮助我们进行QwQ-32B 电脑本地部署,Ollama提供了丰富的预训练模型,覆盖多种自然语言处理任务,如文本生成、翻译和问答。并且ollama支持离线使用,特别适合注重隐私保护或网络不稳定的用户。Ollama安装包下载后就可以用于教学、研究以及开发和测试新的自然语言处理中了。

第一步:安装Ollama

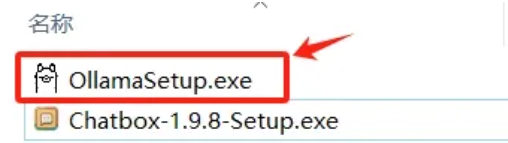

1.下面开始安装Ollama,首先双击“OllamaSetup.exe”

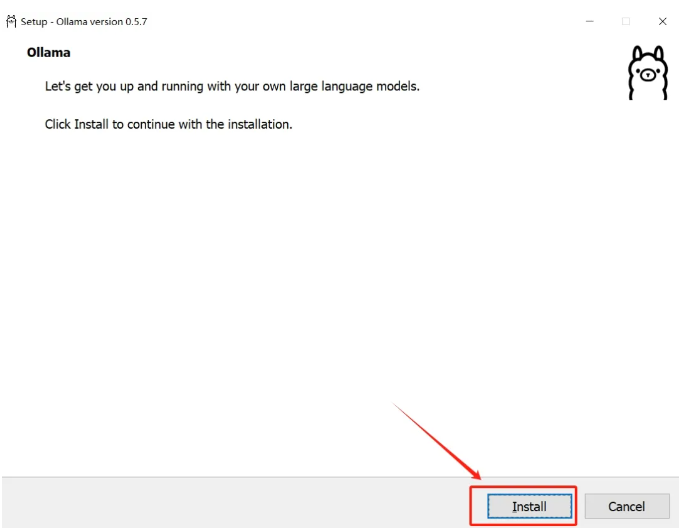

2.由于Ollama安装过程是全英文的,点击【Install】然后根据提示一直确定即可。

3.进度条跑完,Ollama安装完毕。在开始菜单找到并双击Ollama,即可启动软件。

第二步:安装DeepSeek模型

1.在安装好Ollama后,下面我们就要开始安装DeepSeek模型了。

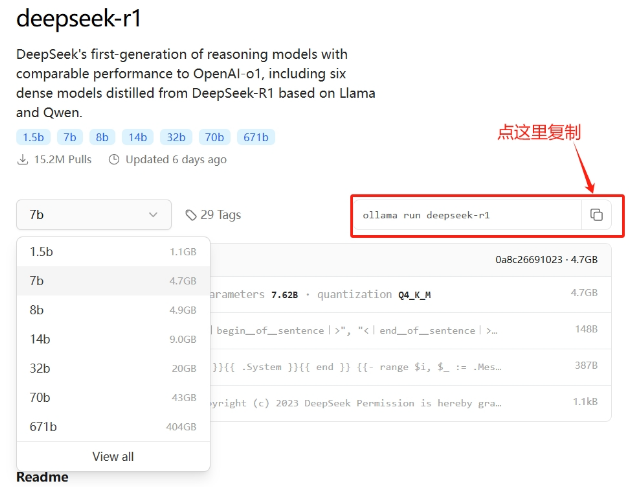

2.在Ollama网页https://ollama.com/library/deepseek-r1,我们可以看到模型。

3.至于DeepSeek模型如何选择,大家需要根据自己的电脑性能进行选择

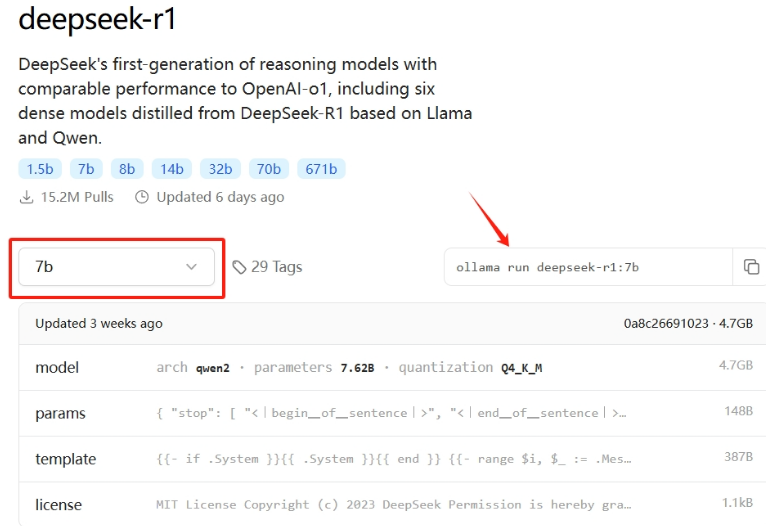

4.推荐大家使用7B,一般的电脑配置都能带起来,32B对电脑的要求比较高,选择7B的话则复制“ollama run deepseek-r1:7b”

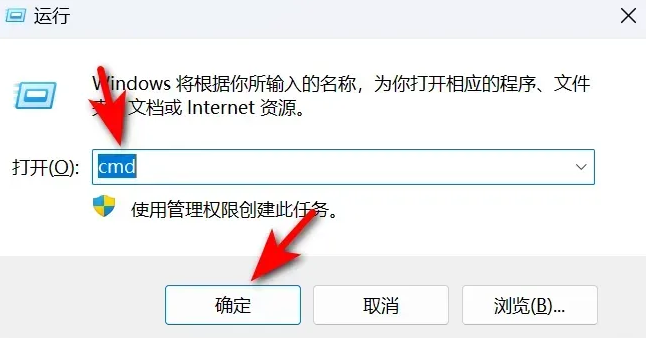

5.在我们的键盘按下“Win键+R”,输入“cmd”打开命令行窗口。

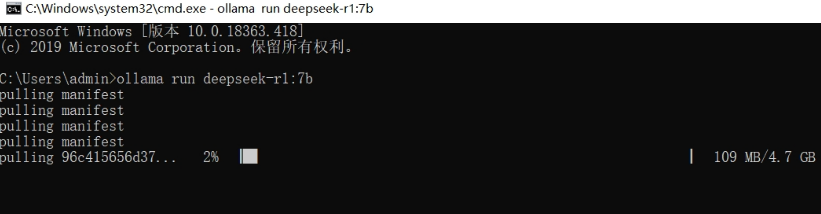

6.在下面的然后输入上面的那串文字“ollama run deepseek-r1:7b”,按回车即可,如下图所示,下载的速度有点慢,大家耐心等待即可。

下载的速度有点慢,大家耐心等待即可。

当出现“success”时,即安装成功了,就可以运行了。

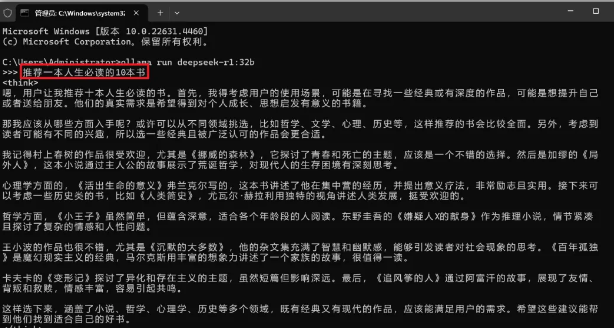

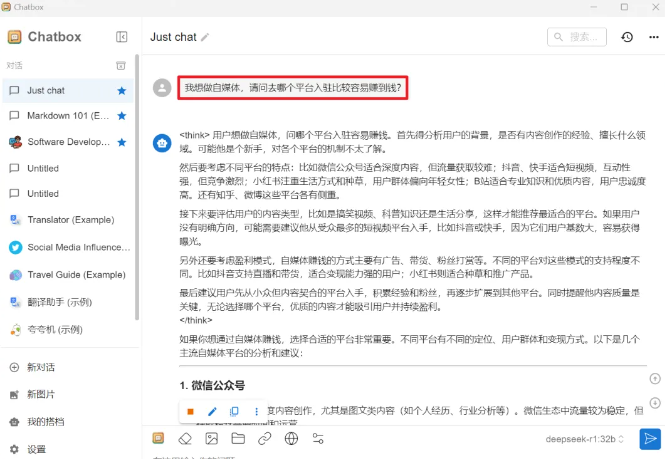

这时候你如果不要UI运行,则用命令窗口直接输入你想要的问题,DeepSeek就开始深度搜索,然后给出你想要的答案。

第三步:安装ChatBox

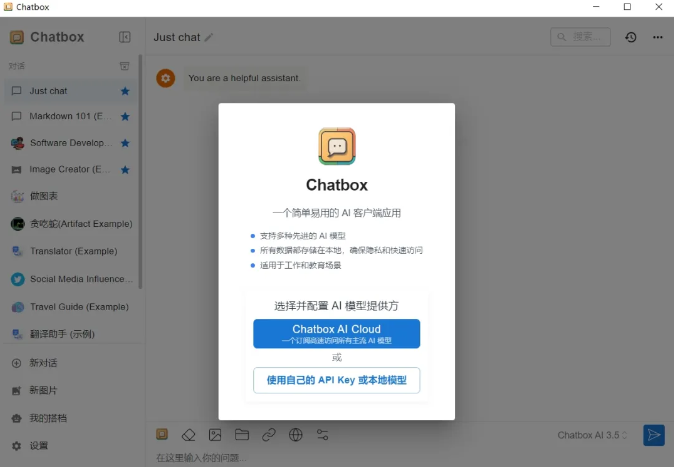

Chatbox是一个用于与本地AI模型交互的前端工具,安装很简单,只需双击安装包并按照提示完成安装即可

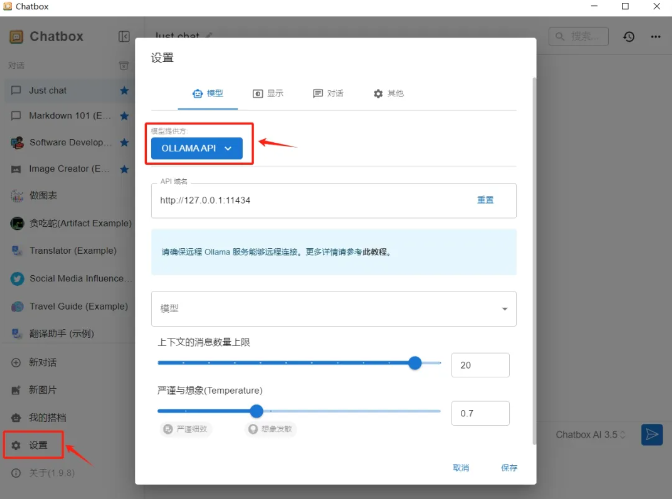

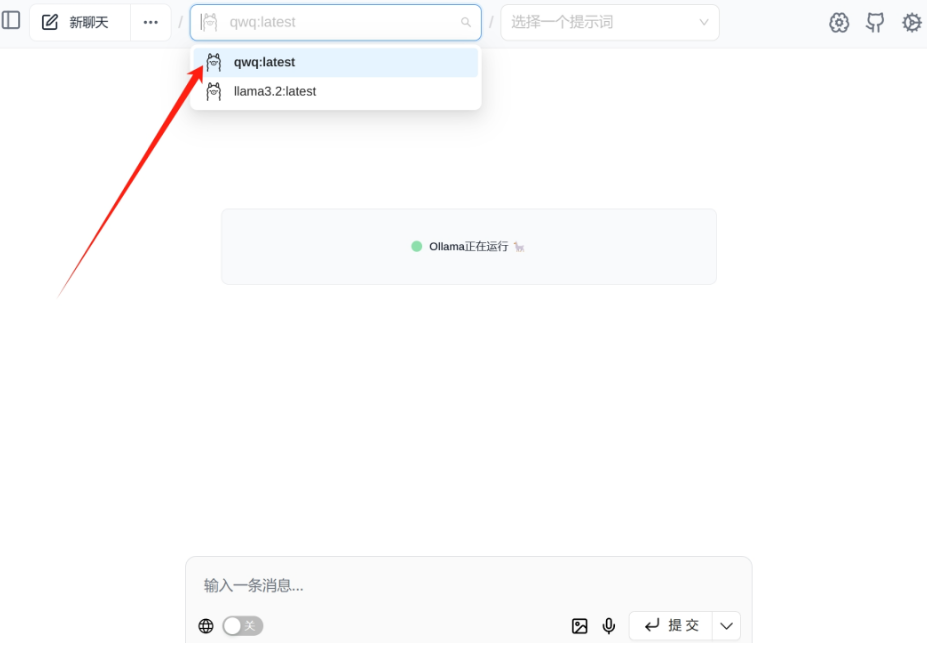

如何在 Chatbox 中连接本地 Ollama 服务:

安装完成后,我们打开Chatbox,点击左边的【设置】然后选择“OLLAMA API”,如果我们已经安装好了第二步的DeepSeek模型,即可在模型下拉框中看见你运行的本地模型,点击保存即可。

选择保存即可,然后我们就可以调用DeepSeek进行对话了,输入你的问题,软件会给出你想要的答案。

Ollama是一个开源的大型语言模型(LLM)服务工具,它支持在本地调用大型模型。DeepSeek等大模型的调用正是基于Ollama平台实现的。

1.Ollama支持同时加载多个模型和单个模型处理多个请求

2.扩展功能有前端工具、自定义模型、资源管理等

3.支持单模型多请求

1.模型管理和API支持,还有跨平台特性

2.Ollama支持的模型种类多,比如Llama3、Mistral等

3.Ollama轻量级,占用资源少,适合本地运行

4.Ollama适合需要数据隐私的场景

1.EST API 兼容 OpenAI

2.技术架构(如多模型并发、API 兼容性)与社区支持(如丰富的前端界面)

3.支持 Windows(预览版)、macOS、Linux 及 Docker,Windows 用户可通过安装包快速部署,Linux 用户可一键脚本安装